Die Grenzen von ChatGPT im Unternehmenskontext: Ein kritischer Blick

Alles hat mit einem Hype begonnen

Denken Sie beim Thema Künstliche Intelligenz auch noch immer direkt an ChatGPT? Es liegt auf der Hand – warum nicht eine bekannte Technologie nutzen, die einfach zu implementieren scheint?

ChatGPT verzeichnete ein beispielloses Wachstum in der Nutzerbasis. Innerhalb von nur zwei Monaten nach seiner Veröffentlichung im November 2022 erreichte ChatGPT 100 Millionen Nutzer. Dies machte es zur am schnellsten wachsenden Verbraucher-App in der Geschichte, was das enorme Interesse und die schnelle Verbreitung verdeutlicht.

Ein wesentlicher Faktor für diesen Hype war die kostenlose Verfügbarkeit während der Testphase, die es einer breiten Öffentlichkeit ermöglichte, die Fähigkeiten des Modells zu testen. Die Benutzerfreundlichkeit und die Fähigkeit, menschenähnliche Antworten zu generieren, trugen ebenfalls zur Begeisterung bei.

Die Medien spielten eine große Rolle bei der Verbreitung des Hypes. Zahlreiche Berichte und Diskussionen in Nachrichtenportalen und sozialen Medien steigerten das Bewusstsein und das Interesse an GPT. Screenshots von Interaktionen mit dem Chatbot wurden weit verbreitet, was die Neugier und das Engagement weiter anheizte.

Die Einführung von ChatGPT führte zu einem Bewusstseinswandel in der Gesellschaft und der Wirtschaft. Unternehmen und Einzelpersonen erkannten die potenziellen Anwendungsgebiete und Vorteile von KI Technologien wie Large Language Models, was eine Welle von Investitionen und Entwicklungen im Bereich der künstlichen Intelligenz auslöste.

Grenzen von ChatGPT im Unternehmenskontext

Trotz des Hypes gab es zunehmend Kritik und Diskussionen über die tatsächlichen Fähigkeiten und Grenzen von ChatGPT. Wir und andere Experten betonen, dass die Technologie zwar praktisch ist, aber im Unternehmenskontext nicht den gewünschten Effekt erzielt. Diese Perspektiven führten zu einer differenzierten Betrachtung des Hypes, da große Sprachmodelle im Unternehmensumfeld auf inhärente Beschränkungen stoßen

Kurzer Disclaimer

ChatGPT ist das bekannteste große Sprachmodell bzw. Large Language Model (LLM) auf Basis Generative KI. Allerdings betreffen die folgenden Herausforderungen alle LLMs, einschließlich anderer bekannter Modelle wie BERT, LaMDA, PaLM von Google und LLaMA von Meta . LLMs sind KI-Modelle, die darauf trainiert sind, menschenähnliche Texte zu generieren, indem sie große Mengen an Daten analysieren und Muster erkennen. Im Folgenden beziehen wir uns häufig auf alle LLMs, um die allgemeinen Herausforderungen zu erläutern und sich nicht auf ChatGPT zu beschränken.

Halluzinationen

Eine der größten Hürden sind sogenannte Halluzinationen, bei denen das Modell falsche oder ungenaue Informationen generiert. Wir kennen es doch alle: Man fragt nach biografischen Fakten über sich selbst und plötzlich behauptet ChatGPT, dass man einen prestigeträchtigen Preis gewonnen oder an einer Elite-Universität studiert hat – obwohl dies gar nicht der Wahrheit entspricht. Worüber man selbst noch lachen kann, stellt dieses Phänomen im kritischen Unternehmenskontext ein großes Problem dar. Stellen Sie sich vor, ein Unternehmen im Finanzsektor verlässt sich auf ChatGPT für Marktanalysen und erhält plötzlich fiktive Daten über Markttrends. Solche Fehlinformationen können ernsthafte Konsequenzen haben, wenn Geschäftsentscheidungen auf falschen Informationen basieren.

Künstliche Intelligenz soll und kann allerdings im Stande sein, zuverlässige Informationen zu liefern und eine ernstzunehmende Unterstützung sein. Mit diesem Status Quo wollen wir uns ja nicht langfristig zufrieden geben, oder?

Mangelnde Transparenz

Ein weiteres Problem ist die mangelnde Transparenz der Technologie. Die zugrunde liegende Transformer-Architektur macht es oft schwierig, die Quelle der Informationen nachzuvollziehen. Vielleicht haben Sie schon einmal eine präzise Antwort von ChatGPT erhalten und sich gefragt: „Woher kommt diese Information eigentlich?“ Ohne eine klare Nachverfolgbarkeit der Quellen ist es schwierig, die Antworten zu überprüfen und zu validieren.

Zusätzlich werfen LLMs auch Bedenken hinsichtlich der Ethik in der KI und in Bezug auf soziale Fragen auf. Sie können bestehende Vorurteile und Diskriminierungen in den Trainingsdaten reproduzieren und verstärken. Dies kann zu unerwarteten und potenziell schädlichen Antworten führen. Bias und Interpretationsfehler sind dabei häufige Probleme. Es ist oft unklar, wer für die von LLMs generierten Inhalte verantwortlich ist, insbesondere wenn diese zu Schaden führen. Diese mangelnde Transparenz und die rechtlichen Risiken können somit ernsthafte Konsequenzen für Unternehmen haben.

Rechtliche Unsicherheiten

Rechtliche Unsicherheiten bestehen ebenfalls im Zusammenhang mit den von LLMs generierten Inhalten. Urheberrechtsverletzungen können auftreten, wenn die Modelle Texte generieren, die bestehende urheberrechtlich geschützte Inhalte ohne ordnungsgemäße Quellenangabe verwenden. Stellen Sie sich vor, ChatGPT generiert einen Text, der Teile eines urheberrechtlich geschützten Buches enthält, ohne dies zu kennzeichnen. Dies könnte rechtliche Probleme für Ihr Unternehmen bedeuten, insbesondere wenn dieser Inhalt in offizielle Dokumente oder Veröffentlichungen einfließt.

Begrenzter Zugang zu proprietären Daten

Der Zugang zu proprietären Daten ist ein zweischneidiges Thema. LLMs wie ChatGPT greifen hauptsächlich auf öffentlich zugängliche Quellen zurück und können daher nicht auf spezifische oder vertrauliche Unternehmensinformationen zugreifen. Es sei denn, man lädt ein zu untersuchendes Dokument hoch. So kann man der KI Zugang verschaffen, damit sie damit interagiert und kontextbezogene Antworten liefert. Aus pragmatischer Sicht ist dies ein schlauer Schachzug im Falle eines öffentlichen, intransparenten LLMs jedoch nicht, da die Sicherheit und Vertraulichkeit der Daten nicht gewährleistet werden kann. Proprietäres Wissen ist jedoch entscheidend für die effektive Nutzung von KI in Unternehmen, da es ermöglicht, spezifische Anforderungen und Kontexte besser zu berücksichtigen.

Datenschutzprobleme

Spinnen wir den Problem-Faden aber erstmal weiter: Datenschutzverletzungen können auftreten, wenn LLMs unabsichtlich diese vertrauliche Informationen preisgeben. Erinnern Sie sich an die Nachrichten, als Italien ChatGPT vorübergehend blockierte, weil Datenschutzbedenken bestanden? Oder als mehrere Unternehmen die Nutzung von ChatGPT für vertrauliche Daten untersagten? Diese Vorfälle zeigen, dass während der Zugang zu proprietären Daten für maßgeschneiderte Antworten wichtig ist, die Nutzung solcher Daten das Risiko birgt, dass sensible Informationen ungewollt offengelegt werden.

Wie können Sie also solche Vorteile nutzen, ohne die möglichen Risiken einzugehen?

Fehlendes Langzeitgedächtnis

Nehmen wir an das Missbrauchrisiko wäre gelöst, dann ist bei einem LLM das nächste Hindernis ein fehlendes Langzeitgedächtnisses. Sie können nur den Kontext innerhalb eines begrenzten Textumfangs berücksichtigen, was ihre Nützlichkeit in längeren oder komplexeren Interaktionen einschränkt. Das bedeutet in der Praxis: Wiederholtes Einpflegen aller Kontext-spezifischen Dokumente, Angaben und Anweisungen und das ohne Ende. Vielleicht haben Sie versucht, eine längere Diskussion mit ChatGPT zu führen, und festgestellt, dass es sich nicht mehr an frühere Teile des Gesprächs erinnert. Dies bedeutet, dass LLMs Schwierigkeiten haben, den Überblick über längere Gespräche oder komplexe Themen zu behalten. Stellen Sie sich vor, Sie arbeiten an einem langfristigen Projekt und müssen immer wieder denselben Kontext erklären – das ist nicht nur ineffizient, sondern auch frustrierend.

Das Bauen eigener GPTs bietet auf den ersten Blick einen möglichen Ausweg aus diesem Defizit, aber diese brauchen auch regelmäßige manuelle Wartung und beinhalten natürlich weiterhin die anderen oben genannten Probleme, die weitaus kritischer zu behandeln sind.

Die Schlussfolgerung zu hierzu ist, dass diese Modelle zum jetzigen Stand unzureichend, unzuverlässig und unsicher für die Nutzung im Unternehmen sind.

Branchenanpassung und spezifische Lösungen

Im Unternehmenskontext hat es zunächst höchste Priorität, Halluzinationen zu vermeiden. Antworten MÜSSEN zuverlässig, sicher und korrekt sein, wenn daran kritische Entscheidungsfindung ausgemacht wird.

Dafür benötigt man eine KI mit:

- Branchenspezifischem Wissen

- Kontextverständnis

- Datenintegrität und Compliance

Die Zukunft der KI im Unternehmensumfeld

Es gibt bereits vielversprechende Aussichten. Wie wir in unserem Artikel „Die Zukunft der KI: Was erwartet uns?“ beschrieben haben, prognostiziert Gartner:

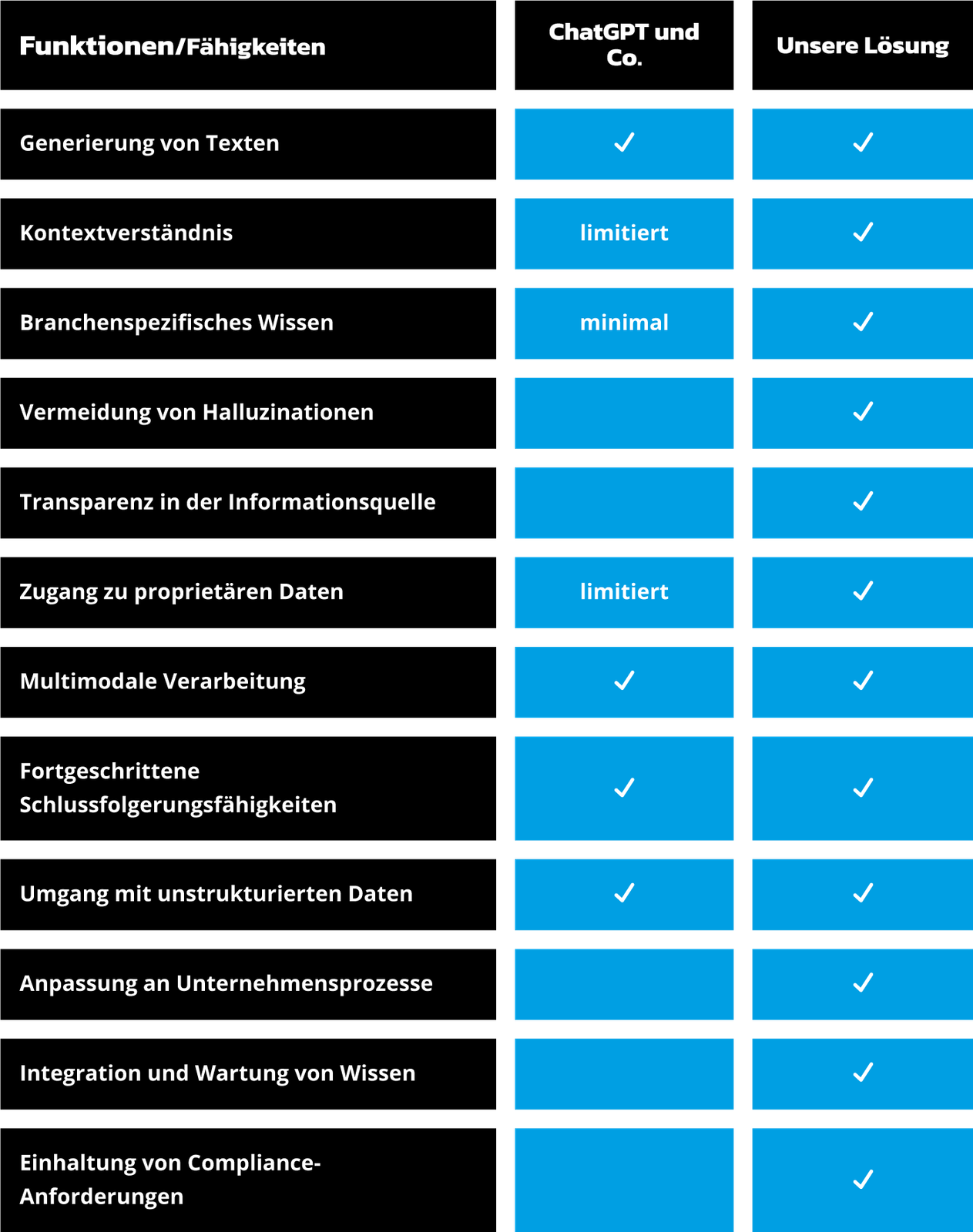

Genau daran arbeiten wir bereits. Unsere branchenspezifischen Systeme werden frei von den Komplikationen generischer LLMs sein. Sehen Sie selbst:

Vergleich der Funktionen und Fähigkeiten von ChatGPT und unserer spezialisierten Lösung im Unternehmenskontext. Die Tabelle zeigt die Vorteile unserer Lösung in Bereichen wie Kontextverständnis, branchenspezifisches Wissen, Vermeidung von Halluzinationen und Einhaltung von Compliance-Anforderungen.

Fazit

ChatGPT ist aufgrund seiner Halluzinationen und mangelnder Transparenz keine verlässliche Option für Unternehmen. Die Situation wird durch die Anforderungen der DSGVO und des kommenden EU AI Act verschärft. Diese Regulierungen verlangen eine hohe Transparenz und Zuverlässigkeit, die ChatGPT nicht bieten kann.

Kontaktieren Sie uns, um zu erfahren, wie Sie sich bereits jetzt richtig aufstellen und der Konkurrenz mindestens drei Schritte voraus sein können.