Retrieval Augmented Fine-Tuning (RAFT): Wie Sprachmodelle mit neuem Wissen schlauer werden

Einführung

Künstliche Intelligenz und insbesondere große Sprachmodelle Large Language Models (LLMs) spielen eine entscheidende Rolle in der heutigen Informationsgesellschaft. Sie lernen aus riesigen Mengen von Texten, um menschenähnlich zu verstehen und zu kommunizieren. Doch was geschieht, wenn sie auf neue Informationen stoßen, die nicht in ihren ursprünglichen Trainingsdaten enthalten sind? Hier greift der Ansatz des Retrieval Augmented Fine-Tuning (RAFT), der darauf abzielt, Sprachmodelle weiterzuentwickeln und „schlauer“ zu machen. Dieses Konzept baut auf der früheren Methode „Retrieval Augmented Generation“ (RAG) auf. Es nutzt fortgeschrittene Algorithmen und zielt auf die Modelloptimierung ab, um den Inhalt umfassend zu erklären.

Grundlagen von RAG (Retrieval Augmented Generation)

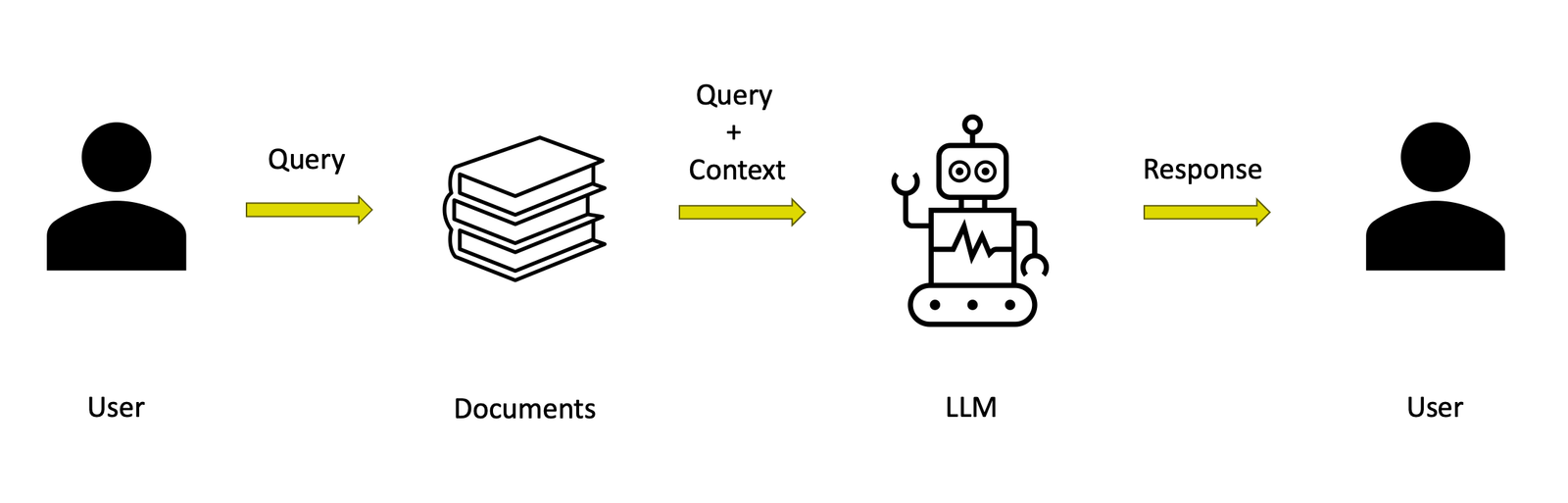

RAG ist eine Technik bei der ein Sprachmodell verwendet wird, um auf Nutzerfragen zu antworten. Dafür ruft es relevante Informationen aus einer großen Datenbank ab. Man kann sich ein Sprachmodell wie einen virtuellen Assistenten vorstellen, der Zugriff auf eine umfangreiche Bibliothek von Informationen hat. Wenn eine Frage gestellt wird, sucht das Modell in dieser Bibliothek nach relevanten Informationen und verwendet diese für die Antwort. Ein Beispiel hierfür ist eine Anfrage über „IR“. Sie könnte sowohl als „Imperial Roman Army“ als auch „Information Retrieval“ interpretiert werden. Das Modell zeigt jedoch Schwächen, wenn es irrelevante Informationen abruft oder das Kontextverständnis der Anfrage nicht vollständig nutzt.

Veranschaulichung des RAG-Prozesses, der zeigt, wie ein Sprachmodell auf komplexe Anfragen reagiert und dabei verschiedene Interpretationen berücksichtigt.

Einführung in RAFT (Retrieval Augmented Fine-Tuning)

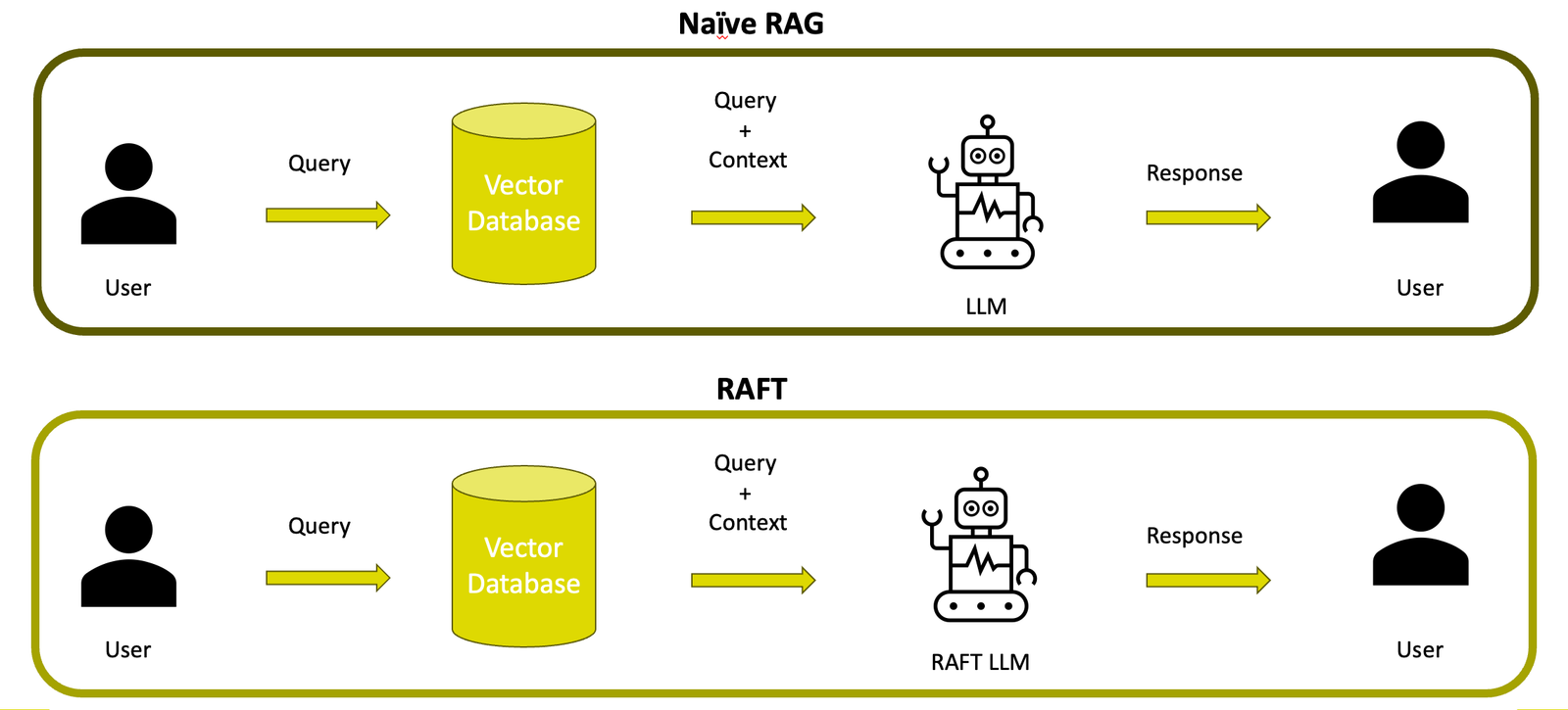

RAFT erweitert RAG, indem es das Sprachmodell speziell anpasst, um besser mit den abgerufenen Informationen umgehen zu können. Es verbessert die semantische Analyse der abgerufenen Dokumente, was zu präziseren Antworten des Modells führt.

Das Hauptziel von RAFT ist es, dass Sprachmodelle effektiver und spezifischer auf die Bedürfnisse des Nutzers eingehen können. Dies wird erreicht, indem das Modell nicht nur allgemein auf viele Informationen trainiert wird. Es wird stattdessen speziell auf die Domäne oder die Spezifikationen der Daten trainiert, die für die Nutzeranfragen relevant sind.

Man kann sich das ganze als ein fortgeschrittenes Schulungsprogramm vorstellen, das Sprachmodellen hilft, sich auf bestimmte Themen zu spezialisieren. Es werden gleichzeitig unnötige Informationen ausgeblendet. Dieses Programm ist besonders nützlich, wenn das Modell auf neue, zeitkritische Nachrichten oder spezifisches Fachwissen aus einer Branche trifft. RAFT hilft dabei, dieses Wissen effektiv zu integrieren. Zudem verbessert es die Fähigkeit des Modells, gezielt die nützlichsten Informationen aus einer Reihe von Dokumenten zu extrahieren. Wenn eine Frage gestellt wird, ignoriert das Modell dank RAFT alle irrelevanten „Ablenkungsdokumente“. Stattdessen konzentriert es sich darauf, die genaue Antwort aus den relevanten Texten zu zitieren. Diese Methode steigert nicht nur die Genauigkeit der Antworten, sondern auch das analytische „Denken“ des Modells.

Darstellung der Effizienzsteigerung in der Informationsverarbeitung und Antwortgenauigkeit durch Einsatz von RAFT (Retrieval Augmented Generation) im Vergleich zu Naives RAG.

Wie funktioniert RAFT ?

Feinabstimmung und Nutzung von spezifischen Dokumenten

In RAFT wird das LLM mit spezifischen Dokumenten feinabgestimmt. Das bedeutet es lernt aus Dokumenten, die speziell für den Kontext des Nutzers ausgewählt wurden. Das kann man sich vorstellen wie bei einem Schüler. Anstelle von umfassenden Lernen wird gezielt auf bestimmte Themen, die in einer Prüfung vorkommen werden gelernt. Dies verbessert das Verständnis und die Antwortgenauigkeit des Modells erheblich.

Erzeugung synthetischer Daten

Ein interessanter Aspekt von RAFT ist die Erzeugung synthetischer Daten. Das Sprachmodell verwendet echte Benutzeranfragen und die zugehörigen Antworten, um künstliche (synthetische) Fragen und Antworten zu generieren. Diese dienen dann dazu, das Modell weiter zu trainieren. Das wird wirksam, indem sie es herausfordern, auf neue und unbekannte Anfragen richtig zu reagieren.

Chain of Thought (CoT)

Eine spezielle Methode in RAFT ist die „Chain of Thought“. Hierbei der das Modell angeleitet wird, seine Gedankengänge in Schritten darzulegen, bevor es eine endgültige Antwort gibt. Das ähnelt der Herangehensweise, wie ein Mensch ein Problem Schritt für Schritt durchdenkt, bevor er eine Lösung präsentiert. Diese Methode hilft dem Modell, logischer und transparenter in seinen Antworten zu sein.

Oracle- und Distractor-Fragmente

Um die Qualität der Antworten zu testen und zu verbessern, verwendet RAFT zwei Arten von Informationsblöcken. Zum einen „Oracle“-Fragmente, die direkte und korrekte Antworten auf eine Anfrage enthalten. Zum anderen „Distractor“-Fragmente, die irrelevante Informationen enthalten. Diese dienen dazu, das Modell darauf zu trainieren, relevante von irrelevanten Informationen zu unterscheiden.

Anwendungsbereiche von RAFT

RAFT wird überall dort eingesetzt, wo Genauigkeit und Aktualität der Information entscheidend sind. Es dient als Grundlage für fortschrittliche Chatbots, die durch bessere Textgenerierung und verbessertem Algorithmus effektiver kommunizieren können.

Im rechtlichen Bereich kann RAFT schnell relevante Gesetze und Präzedenzfälle identifizieren. Dies hat das Potenzial die Rechtsfindung zu beschleunigen und die Genauigkeit juristischer Dokumentationen zu erhöhen.

In der Medizin unterstützt RAFT Diagnose und Behandlung durch den Zugriff auf aktuelle Forschungsergebnisse und klinische Daten.

RAFT ermöglicht es Finanzanalysten, Echtzeit-Marktdaten und Wirtschaftsberichte zu integrieren. Diese Fähigkeit ist entscheidend für genaue Marktprognosen und fundierte wirtschaftliche Analysen.

Chancen und Limitationen

Die Effektivität von RAFT wurde bereits in verschiedenen Bereichen getestet, darunter medizinische Forschung, Quizfragen-Datenbanken und mehr. Die Ergebnisse zeigen, dass mit RAFT Modelle besser in der Lage sind, präzise und relevante Informationen zu liefern. Darüber hinaus ermöglicht RAFT das Fine Tuning von Modellen für spezifische Domänen. Diese maßgeschneiderte Anpassung steigert den Wert der Modelle für branchenspezifische Anwendungen.

RAFT-Modelle passen sich durch die Nutzung dynamischer Informationen in der Textverarbeitung an neue Daten an. Dies funktioniert ohne vollständig neu trainiert werden zu müssen. Dies ermöglicht eine kontinuierliche Aktualisierung und Skalierung der KI-Modelle mit minimalen Anpassungen. RAFT repräsentiert einen signifikanten Fortschritt in der Entwicklung von KI-Software, indem es eine stärkere Anpassung an spezifische Informationsanforderungen ermöglicht.

Obwohl RAFT viele Vorteile bietet, gibt es auch Herausforderungen bei seiner Implementierung. Die Qualität der Ergebnisse hängt stark von der Qualität und der Vielfalt der Daten ab. Zudem können Datenschutzbedenken entstehen, besonders wenn sensible Informationen verarbeitet werden müssen. Es ist auch wichtig zu beachten, dass RAFT eine komplexe Infrastruktur erfordert, was die Implementierung in ressourcenbeschränkten Umgebungen erschweren kann.

Schlussfolgerung

Zusammenfassend ist RAFT eine innovative Methode. Sie zielt darauf ab, Sprachmodelle zu verbessern. Dies gelingt durch gezieltes Training und den Einsatz von fortgeschrittenen Technologien wie CoT und spezifischer Informationsverarbeitung. RAFT ermöglichen es Unternehmen und Einzelpersonen, maßgeschneiderte Lösungen zu entwickeln. Das bedeutet sie sind auf ihre spezifischen Bedürfnisse zugeschnitten. RAFT repräsentiert einen signifikanten Fortschritt in der Entwicklung von KI-Modellen. Es erweitert die Grenzen dessen, was mit künstlicher Intelligenz möglich kontinuierlich.