Deep Dive in die neusten Open-Source-LLM-Tools: LLama-3 und Phi-3

Einführung in die Welt der Open-Source-LLM-Tools: LLama-3 und Phi-3

In der Welt der künstlichen Intelligenz setzen Open-Source-Sprachmodelle wie LLama-3 und Phi-3 neue Standards. Diese fortschrittlichen KI-Modelle verbessern Sprachverständnis und Sprachsynthese.

Als Open-Source-LLM-Tools bieten sie tiefes Kontextverstehen und beeindruckende Natural Language Understanding (NLU)-Fähigkeiten. Sie sind essentiell für die Entwicklung effektiver NLP-Lösungen. Ihre Verfügbarkeit als Open-Source-Lösungen fördert breite Nutzung und kontinuierliche Verbesserung. Damit sind sie wertvoll für akademische und kommerzielle Anwendungen. Dieser Artikel beleuchtet die Technologien und Leistungsmerkmale dieser Modelle. Er zeigt auch Anwendungsfälle auf, die unsere Interaktion mit Maschinen revolutionieren könnten.

Was ist LLama-3?

LLama-3 ist die neueste Iteration der Large Language Model-Familie von Meta AI, bekannt für ihre Spitzenleistung in vielen Kategorien. Obwohl LLama-3 nicht vollständig Open-Source ist, bietet es eine Lizenz mit minimalen Einschränkungen für kommerzielle Nutzung und Verbreitung. LLama-3 wurde mit einem wesentlich größeren Datensatz von etwa 15 Billionen Tokens trainiert, eine siebenfache Steigerung. Dies umfasst auch eine vierfache Erhöhung des Anteils an Code, was das Modell besonders für technische Anwendungen nützlich macht.

Wie ist Llama-3 aufgebaut?

Llama-3 nutzt laut Angaben eine revolutionäre Mixture-of-Experts (MoE) Architektur, die dieses kompakte KI-Modell effizienter und leistungsfähiger macht. Anders als traditionelle dichte Modelle setzt Llama-3 auf einen dynamischen Routing-Mechanismus, der Tokens intelligent an spezialisierte neuronale Netzwerke weiterleitet.

Dieses Design ermöglicht Llama-3, spezialisierte Netzwerke für bestimmte NLP- und Sprachverarbeitungsaufgaben zu nutzen. Durch das gezielte Routing der Tokens erzielt Llama-3 hochwertige Ergebnisse mit weniger Parametern als größere Modelle.

Die MoE-Architektur von Llama-3 setzt auf Spezialisierung statt eines Universalmodells. Jedes Expertennetzwerk ist auf spezielle Aspekte der Sprachverarbeitung ausgerichtet. Dieser modulare Ansatz verbessert nicht nur die Leistung, sondern bietet auch Skalierbarkeit und Flexibilität. Neue Expertennetzwerke können nahtlos integriert werden. Sie erweitern die Fähigkeiten von Llama-3, ohne das gesamte Modell neu schulen zu müssen.

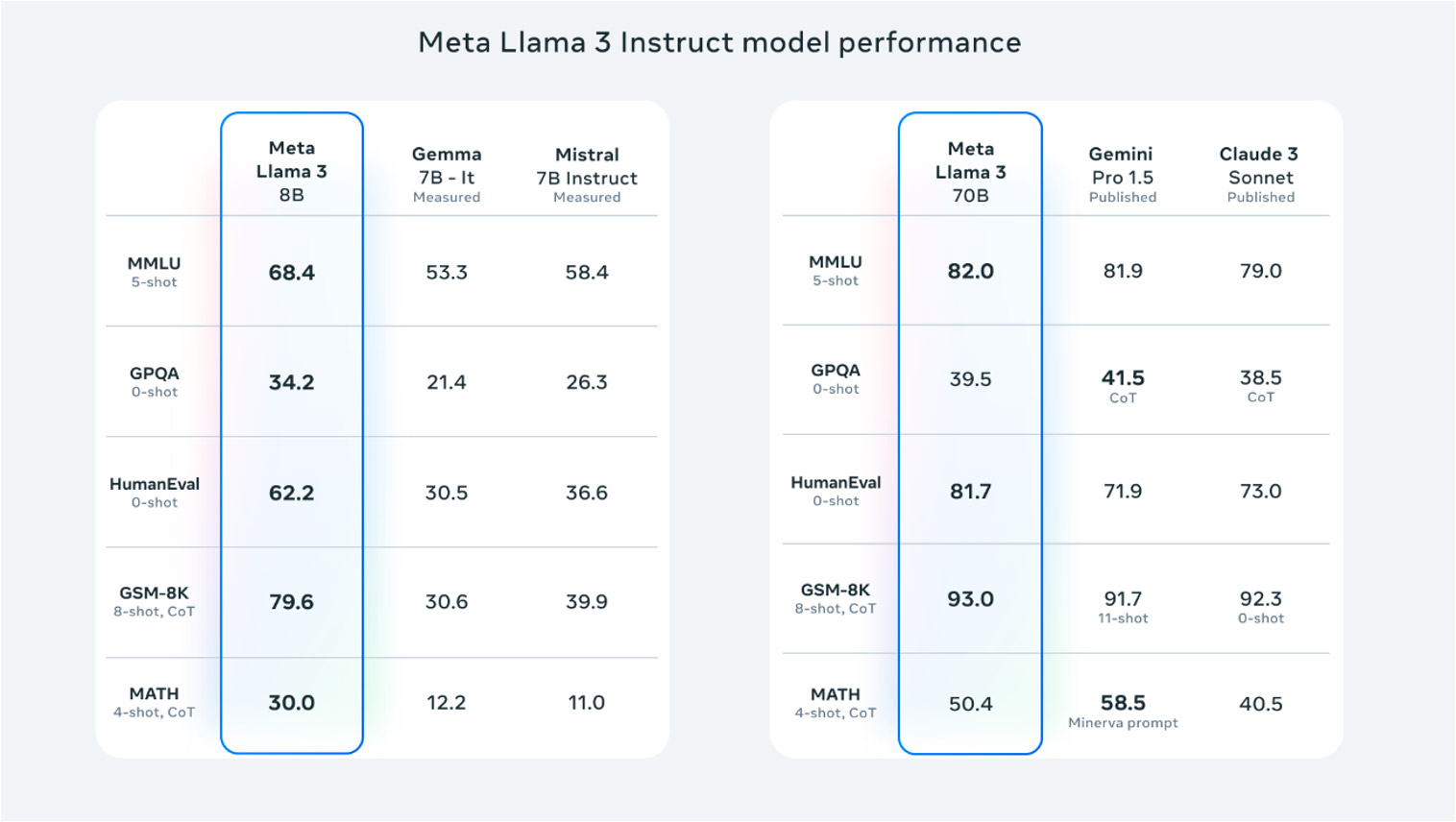

Untenstehend sehen Sie eine Übersicht der Leistungsmerkmale von Llama-3 Instruct in verschiedenen Bewertungskategorien. Dieses Diagramm zeigt, wie Llama-3 im Vergleich zu anderen Modellen wie Gemini und Claude 3 steht. Es stellt die Effektivität der MoE-Architektur in der Praxis dar.

Es stellt die Effektivität der MoE-Architektur in der Praxis dar.

Einführung und Updates in Phi-3

Phi-3, entwickelt von Microsoft, ist ein kompaktes Sprachmodell mit beeindruckenden Fähigkeiten, verfügbar in drei Größen: mini, small und medium. Die mini-Version bietet zwei Kontextlängen-Varianten, wodurch Phi-3 in verschiedenen Natural Language Processing-Anwendungen außerordentlich leistungsstark und kosteneffektiv einsetzbar ist.

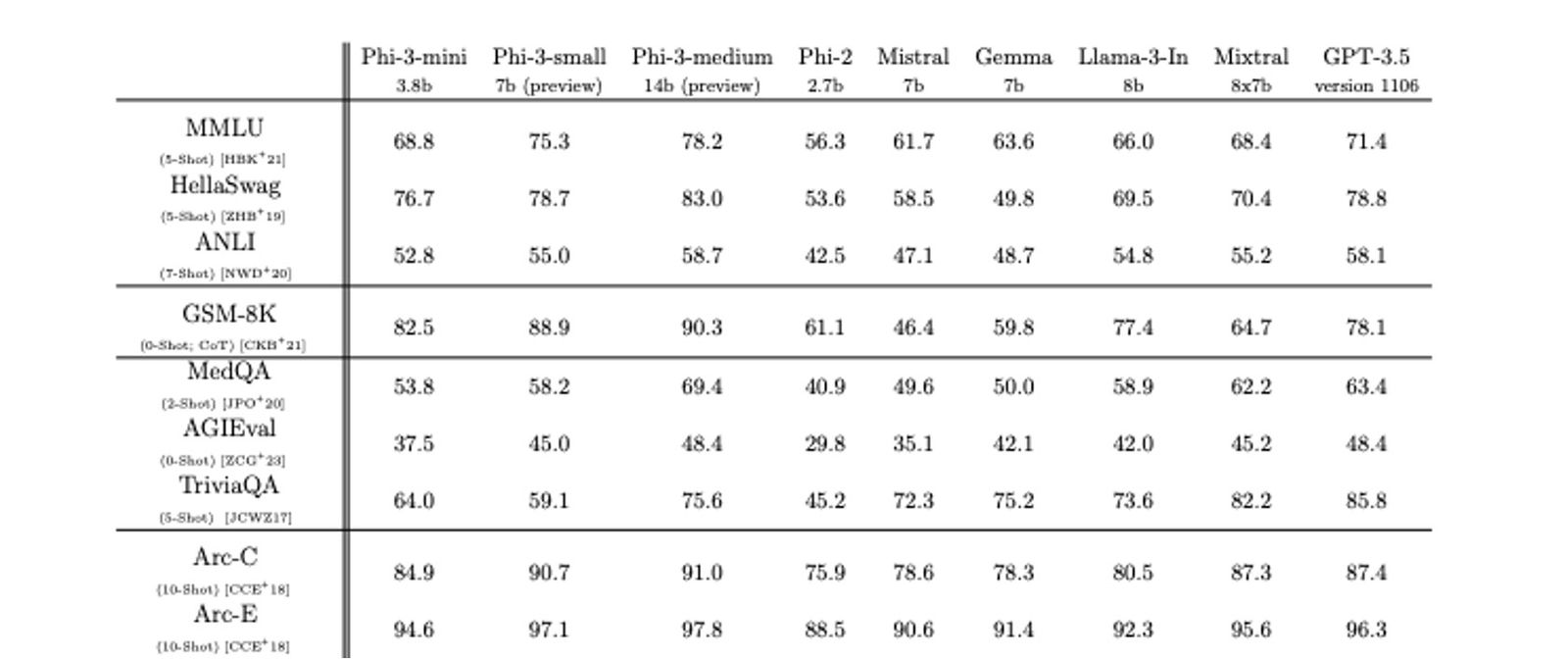

Die folgende Abbildung veranschaulicht die Leistungsfähigkeit verschiedener Sprachmodelle einschließlich Phi-3 in verschiedenen Testumgebungen. Diese Daten zeigen deutlich, wie unterschiedliche Modelle in spezifischen NLP-Aufgaben wie Hellaswag, ANLI und anderen abschneiden. Zudem unterstreichen sie die fortschrittlichen Fähigkeiten von Phi-3 insbesondere in kompakten und mittleren Größen.

Es unterstreicht die fortschrittlichen Fähigkeiten von Phi-3 insbesondere in kompakten und mittleren Größen. Open-Source-LLM-Tools

Möchten Sie mehr über das Pricing von LLMs erfahren? Lesen Sie den kostenlosen Artikel über die Preisgestaltung von Large Language Models unter https://neuland.ai/large-language-model-pricing/, um tiefergehende Einblicke zu gewinnen.

Die Architektur von Phi-3

Ein zentraler Aspekt der Phi-3-Architektur von Microsoft ist die Anwendung der Quantisierungstechnik, durch die Modellgewichte auf niedrigere Präzisionsformate komprimiert werden. Diese Methode reduziert nicht nur die Gesamtgröße des Modells erheblich, sondern steigert auch die Inferenzgeschwindigkeit und Speichereffizienz. Dies macht Phi-3 besonders geeignet für den Einsatz auf einer breiten Palette von Geräten, einschließlich mobiler und eingebetteter Systeme.

Die Quantisierung erfordert eine präzise Balance, um die Modellgenauigkeit zu wahren. Dabei werden die Berechnungsressourcen minimiert. Microsofts Forscher haben ausgeklügelte Quantisierungsalgorithmen entwickelt. Diese ermöglichen den Phi-3-Modellen, trotz Kompaktheit und Effizienz, bemerkenswerte Leistungen.

Neben der Quantisierung verwenden Phi-3-Modelle weitere fortgeschrittene Techniken. Dazu zählen Wissensdestillation und Modellbeschneidung. Diese Methoden optimieren Leistung und Effizienz weiter. Sie ermöglichen auch effektives Lernen von größeren, komplexeren Modellen. Gleichzeitig behalten sie ihre kompakte Größe und schnelle Verarbeitungsfähigkeit bei. Solche Techniken sind entscheidend, um die Anwendbarkeit von KI-Modellen in ressourcenbeschränkten Umgebungen zu maximieren. Sie spiegeln den aktuellen Stand der Technik in der Sprachverarbeitungsmodell-Entwicklung wider.

Llama-3 und Phi-3: Diskussion ihrer Chancen und Schwächen

Llama-3 nutzt eine effiziente Mixture-of-Experts (MoE) Architektur, die beeindruckende Ergebnisse mit weniger Parametern ermöglicht. Dies macht das Modell effizienter und einfacher in der Anwendung. Die modulare Architektur bietet Skalierbarkeit und Flexibilität, indem sie neue Expertennetzwerke nahtlos integriert. Dies erweitert die Fähigkeiten von Llama-3 ohne komplette Neuschulung, ideal für dynamische Domänen.

Allerdings könnte Llama-3 bei komplexeren Aufgaben Probleme haben, mit größeren Modellen wie GPT-4-turbo oder Claude-Opus zu konkurrieren. Die Komplexität des dynamischen Routings erhöht die Gesamtkomplexität und benötigt zusätzliche Rechenressourcen sowie umfangreiche Optimierungen.

Phi-3 bietet durch fortschrittliche Schulungstechniken und Optimierungen wie Quantisierung Kompaktheit und Effizienz. Diese Modelle bleiben leistungsfähig und sind ideal für den Einsatz auf verschiedenen Geräten, einschließlich mobiler und eingebetteter Systeme.

Jedoch haben Phi-3-Modelle eine Leistungsgrenze; sie können die Fähigkeiten größerer Modelle bei anspruchsvollen Aufgaben nicht vollständig erreichen. Die Optimierung dieser Modelle, um ein Gleichgewicht zwischen Größe, Leistung und Effizienz zu finden, ist ein komplexer und ressourcenintensiver Prozess.

Insgesamt bieten Llama-3 und Phi-3 jeweils einzigartige Vorteile in der Sprachmodell-Landschaft. Die Auswahl sollte sorgfältig nach spezifischen Anforderungen und Kontext entschieden werden.

Llama-3 und Phi-3: Potenzielle Anwendungen und Anwendungsfälle

Llama-3 und Phi-3 bieten spannende Möglichkeiten für eine Vielzahl von Anwendungen und Anwendungsfällen. Hier einige Beispiele:

Natürliche Sprachverarbeitung (NLP) Aufgaben

Llama-3 und Phi-3 können in verschiedenen NLP-Bereichen wie Textgenerierung, Zusammenfassung, Fragebeantwortung und Sentimentanalyse eingesetzt werden. Die MoE-Architektur von Llama-3 und die Effizienz von Phi-3 machen sie für unterschiedliche Szenarien besonders geeignet.

Conversational AI

Ihre kompakte Natur prädestiniert diese Modelle für den Einsatz in AI-Assistenten auf ressourcenbeschränkten Geräten wie Smartphones oder IoT-Geräten. Dies eröffnet neue Wege für intelligentere Interaktionen in der Alltagstechnologie.

Eingebettete Systeme

Durch fortschrittliche Quantisierungs- und Optimierungstechniken ist Phi-3 ideal für eingebettete Systeme geeignet. Dies ermöglicht fortschrittliche Sprachfähigkeiten in vielfältigen Anwendungen von Automobilsystemen bis zur industriellen Automation.

Edge Computing

Beide Modelle können in Edge-Computing-Szenarien eingesetzt werden. Ihre kompakte Größe und effiziente Inferenzfähigkeiten ermöglichen die Verarbeitung direkt auf dem Gerät. Dies reduziert Latenzzeiten und verbessert die Privatsphäre.

Multilinguale NLP

Dank ihrer herausragenden Leistung in der maschinellen Übersetzung eignen sich Llama-3 und Phi-3 für mehrsprachige NLP-Aufgaben. Sie ermöglichen die Sprachverarbeitung und -generierung in mehreren Sprachen.

Mit der wachsenden Nachfrage nach KI-Lösungen wird die Bereitstellung von fortschrittlichen Sprachmodellen immer wichtiger. Diese Modelle sind für eine Vielzahl von Geräten und Plattformen entscheidend. Llama-3 und Phi-3 bieten eine optimale Balance zwischen Leistung und Effizienz. Sie schaffen neue Möglichkeiten in verschiedenen Branchen und erweitern das Spektrum möglicher Anwendungen.

Abschließende Gedanken

Die Entwicklung fortschrittlicher KI-Modelle wie Llama-3 und Phi-3 markiert einen Wendepunkt im Bereich des Natural Language Processing (NLP). Diese Open-Source-LLM-Tools verbessern Sprachverständnis und Textgenerierung. Sie bieten erweiterte Fähigkeiten in Kontextverstehen und Sprachsynthese. Durch effiziente Textverarbeitung und -analyse eröffnen sie vielfältige Möglichkeiten. Sie steigern die Kundenerfahrung und automatisieren repetitive Aufgaben. Diese Modelle fördern eine tiefere Interaktion zwischen Mensch und Maschine. Sie erweitern die Grenzen des Möglichen in verschiedenen Anwendungen und Branchen. Die Integration dieser Sprachverarbeitungswerkzeuge hilft Unternehmen, Informationen effizienter zu nutzen. Insbesondere Ihre geringe Größe macht sie zu einer effizienten, schnellen und erschwinglichen Lösung für viele spezialisierte Anwendungsfälle. Sie erschließen neue Perspektiven in der Datenanalyse, was sie zu einem unverzichtbaren Bestandteil moderner Technologielösungen macht.